메타, 아동 성착취 관련 계정 63만개 삭제…안전 기능도 추가

2025-07-24

HaiPress

2025-07-24

HaiPress

DM 경고 강화…아동 등장 성인 계정에도 기능 확대

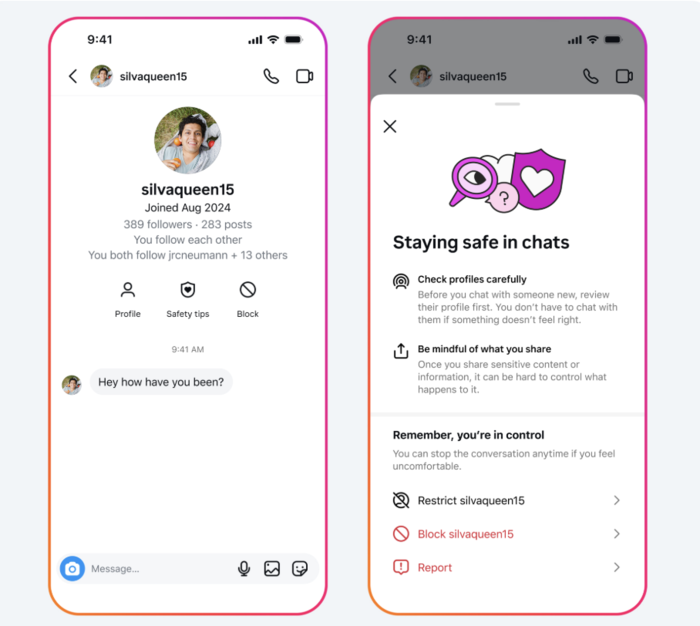

인스타그램 안전 공지 기능. [사진 = 메타] 메타가 자사 플랫폼에서 아동 성적 대상화에 연루된 계정 수십만 개를 삭제하고,청소년 이용자 보호를 위한 새로운 기능을 도입했다.

메타는 23일(현지시간) 공식 블로그를 통해 올해 초 아동이 등장하는 성인 관리 계정에 성적 댓글을 달거나 성적 이미지를 요청한 인스타그램 계정 약 13만5000개를 삭제했다고 밝혔다. 이와 연결된 추가 페이스북 및 인스타그램 계정 약 50만개도 함께 삭제했다. 이로써 총 63만 개 이상의 계정이 제거된 셈이다.

청소년 보호를 위한 추가 조치도 함께 발표했다. 인스타그램 다이렉트 메시지(DM)의 ‘안전 공지’ 기능이 가장 엄격한 등급으로 강화돼,청소년 사용자들이 잠재적으로 위험한 계정으로부터 보호받을 수 있도록 했다.

새로운 대화 상단에는 상대방의 인스타그램 가입 연월이 함께 표시된다. 또한 계정 차단 및 신고 옵션을 통합한 버튼을 추가해 두 가지를 동시에 할 수 있도록 편의성을 높였다.

이 같은 강화된 기능은 주로 어린이가 등장하는 성인 관리 계정에도 확대 적용된다.

메타의 이러한 노력은 실제 효과로도 나타나고 있다. 메타에 따르면 올해 6월 한 달 동안 청소년 사용자들이 100만 개 이상의 계정을 차단했고,안전 공지를 본 뒤 100만 건 이상을 추가로 신고한 것으로 집계됐다.

메타는 또한 플랫폼의 알고리즘을 조정해 10대 사용자에게 차단당한 계정은 더이상 추천에 노출되지 않도록 설정했다고 밝혔다.

메타는 지난해부터 청소년 보호 미비를 이유로 여러 소송에 직면하자 보호 기능을 단계적으로 강화해왔다. 이같은 조치는 인스타그램을 시작으로 페이스북,메신저 등 다른 플랫폼으로도 단계적으로 확대 적용되고 있다.

메타는 “청소년들에게 연령에 맞는 경험을 제공하고 원치 않는 접촉을 방지하도록 설계된 ‘청소년 계정’ 부터 착취 콘텐츠를 찾아내 삭제하는 최첨단 기술까지 다양한 노력을 기울이고 있다”고 강조했다.